Военните действия по света стават все по-автоматизирани, посочва в коментар за СиЕнЕН британският професор по изкуствен интелект и роботика Ноел Шарки. Ние трябва да се запитаме колко далеч искаме и можем да стигнем при делегирането на отговорността при тези конфликти върху роботи, убеден е Шарки, който е и председател на Международния комитет за контрол на роботизираните оръжия.

От хилядолетия насам оръжията се развиват постоянно. Но това значи ли, че трябва да седим спокойни и безразлични, приемайки съдбата си и да предоставим отговорността за убийствата на други хора на машините?

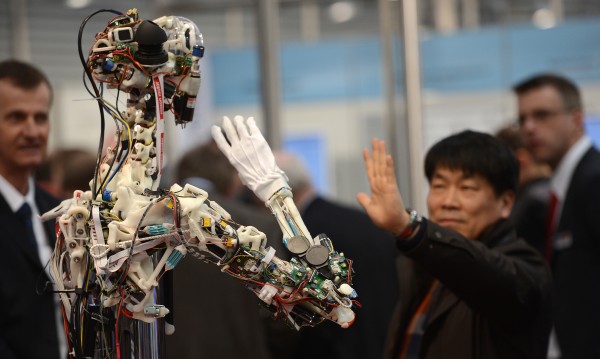

През последните месеци се водят разгорещени дебати относно използването на напълно автономни (взимащи самостоятелни решения) роботизирани оръжия, т.е. въоръжени роботи, които веднъж активирани ще могат сами да избират и елиминират своите цели без човешка намеса.

Според някои мнения роботите биха били по-прецизни на бойното поле в сравнение с хората-войници и така ще бъдат намалени значително цивилните жертви. Но професор Шарки счита, че това са спекулации, базирани на предположения за бъдещето развитие на компютърните хардуер и софтуер. И уточнява, че от 50-те години насам развитието на „изкуствения интелект“ се движи със скоростта на охлюв в сравнение с първоначалните прогнози и очаквания.

Други експерти смятат, че дори и да предположим, че роботите наистина биха били по-прецизни, човечеството не бива да поверява на машината решението за това кой човек ще живее и кой не.

Към настоящия момент не можем да разчитаме на машините да прилагат международното право. Съществуващите подобни оръжия просто не могат да се справят с тази задача. Машините може и да имат съответните адекватни механизми за възприятия, но те не разполагат с жизненоважните компоненти на бойното поле за взимане на съобразени с моментната ситуация обосновани решения кой и кога може да бъде убит.

Роботите не могат да преценят дали нанасянето на удар по зададена цел е пропорционално спрямо очакваното преимущество в битка. За това няма метрика. Говорим за изкуството на войната, не за точна наука.

Един военен командир трябва да прецени дали дадена атака е обоснована за постигането на конкретна цел, предвид рискът от цивилни жертви. И командирът носи цялата отговорност за това решение. С други думи може да бъде изправен пред съда.

При робота този морален аспект го няма. Чуват се мнения, че вината ще се носи от ръководещият съответната мисия, в която участва машината.

Но това на практика не е особено коректно, защото погрешните действия на робота биха могли да бъдат предизвикани от грешка на програмния инженер, на компанията-производител, на всеки един от множеството малки фирми-доставчици на компоненти. Така ще стигнем до едно мъчително проточващо се разследване, което трудно може да завърши с конкретен извод, предвид сложността на технологията.

Професор Шарки посочва, че въпреки всички негативи американското военно министерство съвсем наскоро (ноември 2012-та година) даде зелена светлина за развиване на технологии за автономни оръжейни системи. Според него това изпраща грешен сигнал към останалия свят и реално слага началото на ново военно съревнование на ниво войници-роботи.

Като най-високотехнологичната военна сила в света, Съединените щати носят моралното задължение да спрат използването на роботи с изкуствен интелект в човешки битки, убеден е експертът.

И поставя поредица от сериозни, дори плашещи въпроси: Замисля ли се някой, че тези машини (както всяка друга) могат да бъдат експлоатирани от недоброжелатели (да речем чрез хакерски атаки) и насочвани срещу грешни цели в грешни държави? Замисля ли се някой как тези автономни оръжия са бомба със закъснител и могат да дестабилизират световната сигурност, разпалвайки нежелани военни конфликти?

Множество влиятелни неправителствени организации вече се обединиха в мащабната кампания „Спрете роботите-убийци“. Целта да се въведе законова рамка, възпираща воюващи страни от използването на напълно автономни роботизирани оръжия.

Тази цел все още е постижима. Но ако се стигне до масови национални инвестиции във въпросните технологии, може и да е прекалено късно...

Това се случи Dnes, за важното през деня ни последвайте и в Google News Showcase

Нараства напрежението в Калифорнийския университет, полицията с опит да махне барикадите

Нараства напрежението в Калифорнийския университет, полицията с опит да махне барикадите  Руски бизнесмен обвини Алкарас в уреждане на мачове

Руски бизнесмен обвини Алкарас в уреждане на мачове  Южна Корея повиши равнището на тревога, бие аларма за атаки от КНДР

Южна Корея повиши равнището на тревога, бие аларма за атаки от КНДР  ГЕРБ регистрира листата си в Габрово, водач е Томислав Дончев

ГЕРБ регистрира листата си в Габрово, водач е Томислав Дончев

Програмата на Театър „София“ за май

Програмата на Театър „София“ за май  3 вкусни рецепти за кето козунак (ВИДЕО)

3 вкусни рецепти за кето козунак (ВИДЕО)  10 идеи за великденска декорация, която да си направите сами у дома

10 идеи за великденска декорация, която да си направите сами у дома

Tesla представи своя Cybertruck в Германия

Tesla представи своя Cybertruck в Германия  САЩ отправиха обвинения към Русия, че използва химически оръжия в Украйна

САЩ отправиха обвинения към Русия, че използва химически оръжия в Украйна  Shell изненада с печалба от 7,7 млрд. долара за тримесечието

Shell изненада с печалба от 7,7 млрд. долара за тримесечието  Бивш шеф на Комисията по хазарт: Забраната на хазартната реклама няма да има ефект

Бивш шеф на Комисията по хазарт: Забраната на хазартната реклама няма да има ефект

Стенли отново облича екипа на Селтик

Стенли отново облича екипа на Селтик  Швецайрски национал увисна за Евро 2024

Швецайрски национал увисна за Евро 2024  Тръпката е в Шампионска Лига: 4 отбора, 3 двубоя до края и 1 голям фаворит

Тръпката е в Шампионска Лига: 4 отбора, 3 двубоя до края и 1 голям фаворит  Наско Сираков е длъжен да търси новия Мъри

Наско Сираков е длъжен да търси новия Мъри

Pininfarina създаде новите автомобили на Батман

Pininfarina създаде новите автомобили на Батман  Най-впечатляващите машини, кръстени на легендата Сена

Най-впечатляващите машини, кръстени на легендата Сена  Още една премиум-марка промени електрическите си планове

Още една премиум-марка промени електрическите си планове  Мъск продължи с чистката, махна ключов шеф

Мъск продължи с чистката, махна ключов шеф

Организират Панорама на средното образование във Варна

Организират Панорама на средното образование във Варна  Тъжна вест: Напусна ни художникът Венцеслав Антонов

Тъжна вест: Напусна ни художникът Венцеслав Антонов  Внимание! Дългите празници са любимото за крадците време

Внимание! Дългите празници са любимото за крадците време  Областният информационен център получава 1,42 млн. лв. безвъзмездно финансиране

Областният информационен център получава 1,42 млн. лв. безвъзмездно финансиране

Коментари Напиши коментар